据外媒macrumors报道,新一代Apple AI模型可根据自然语言指令编辑图像,此模型名为MGIE(全称:MLLM-Guided Image Editing),采用多模态大语言模型(MLLMs)解析用户请求并进行像素级别操作。

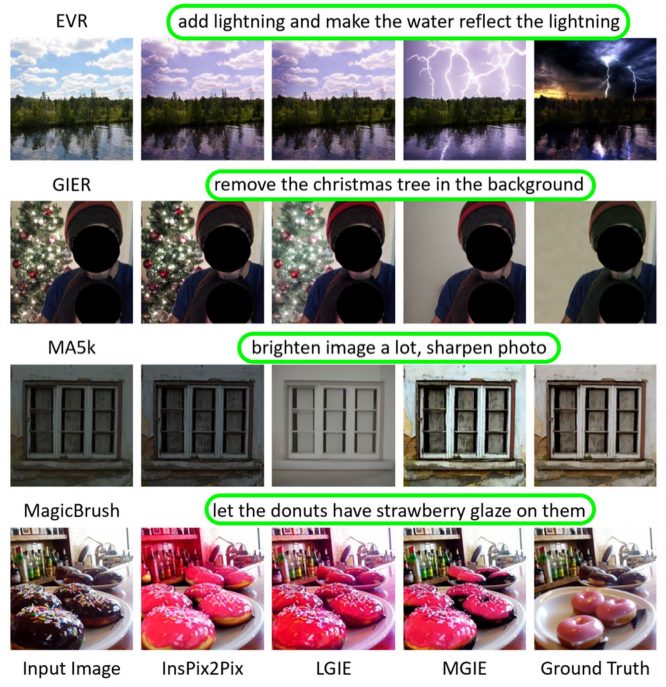

该模型具备多种图像编辑能力。全局图像增强功能包括调节亮度、对比度或锐度等,或添加艺术效果如素描;局部编辑则可以修改特定区域或物体的形状、大小、颜色或纹理,而像Photoshop式的操作则可能涉及裁剪、调整大小、旋转和增加滤镜,甚至更换背景和混合图像。

例如,用户对披萨照片的输入可能是“让它看上去更健康”,基于常识推理,模型可以增添蔬菜配料,如番茄和香草;全局优化Input可能是“增加对比以模拟更多光线”,Photoshop风格修改则可能要求将人从照片背景中移除,将图片注意力集中到主题的面部表情上。

苹果与加利福尼亚大学的研究者共同开发了MGIE,该模型在2024年的国际学习表示大会(ICLR)上发表,并已在GitHub上公开,包含代码、数据和预训练模型。

这是苹果在短短两个月内的第二项AI研究突破。去年12月底,苹果曝光了其通过创新闪存利用技术,在内存有限的iPhone和其他Apple设备上部署大规模语言模型(LLMs)的进展。

苹果一直在试验一种“苹果GPT”竞品,以挑战ChatGPT。据彭博社记者Mark Gurman的报道,AI工作是苹果的优先事项,公司正在为大型语言模型设计一个“Ajax”框架。

据《信息》杂志和分析师Jeff Pu称,苹果预计在2024年末左右将在iPhone和iPad上推出某种生成AI功能,届时iOS 18将问世,该版本的Siri有望搭载像ChatGPT那样的生成AI功能,据Gurman表示,这有可能成为iPhone历史上最大的软件更新之一。