NVIDIA从提出GPU以及CUDA核心开始,NVIDIA便开始逐步迈出游戏圈,不断向全新的计算领域发起攻势。时至今日,NVIDIAGPU计算从机器人、自动驾驶,一路扩展到云计算、医疗甚至是NASA火星登录计划。是的,正如GTC CHINA 2019上,NVIDIA创始人兼CEO黄仁勋所言,就算摩尔定律走向终结,GPU加速计算将有机会成为未来的发展方向,GPU正在变得无所不能,也将无处不在。

以游戏发家的NVIDIA开场少不了游戏的戏份。开场黄仁勋便展示了《我的世界》RTX版本,这也是GTC主题演讲上首次展示《我的世界》RTX视频。通过对光影的添加,这款沙盘化的游戏有了全新的演绎,不仅水面变得更为真实,随着视角、天气、时间变化,光影也呈现出不同的效果。

这套实时光纤追踪技术可以让开发者在添加光源之后,依靠GeForce RTX显卡中的RT Core演算出光线路径,从而获得自然的光线效果,同时也减轻了游戏开发者手动考虑光影贴图的繁琐工作。

除了《我的世界》增加的光线追踪特效,GTC上黄仁勋还宣布了六款游戏正引入光线追踪,包括《边境》(Boundary)、《铃兰计划》(Convallaria)、《暗影火炬》(F.I.S.T.)、Project X(项目代号)、《无限法则》(Ring of Elysium)以及《轩辕剑柒》(Xuan-Yuan Sword VII)。

同时老黄还特意在台上演示了《光明记忆:无限》的光线追踪DEMO。重点在于负责《光明记忆》的飞燕群岛个人工作室主力仅有一人,通过一人之力完成美术、程序以及最新的光线追踪技术功能,也足以见得虚幻引擎对光线追踪已经提供了相当优秀的支持,可以更为轻松调用GeForce RTX的光线追踪功能。

此外,目前宣布支持光线追踪游戏阵营包括:《光明记忆:无限》(Bright Memory: Infinite)、《赛博朋克2077》(Cyberpunk 2077)、《消逝的光芒2》(Dying Light 2)、《我的世界》(Minecraft)、《逆水寒》(Justice)、《剑侠情缘叁网络版》(JX3 Online)、《重生边缘》(SYNCED: Off-Planet)、《仙剑奇侠传七》(Sword And Fairy 7)、《看门狗:军团》《Watch Dogs: Legion》以及《吸血鬼:避世血族2》 (Vampire: The Masquerade – Bloodlines 2)。

在推进光线追踪技术进驻预习的同时,NVIDIA与腾讯游戏合作的START云游戏服务也进入了测试阶段。类似NVIDIA在北美和欧洲推出的GeForce NOW云游戏服务,腾讯START可以让玩家在在配置不足的设备上也能玩AAA游戏。腾讯游戏计划将扩展其云游戏产品。

NVIDIA与腾讯还将成立一个一个游戏联合创新实验室。双方将共同探索AI在游戏、游戏引擎优化和新光照技术(包括光线追踪和光线烘焙)中的新应用。借着START服务东风,英伟达的云游戏技术也终于可以在国内付诸实践。

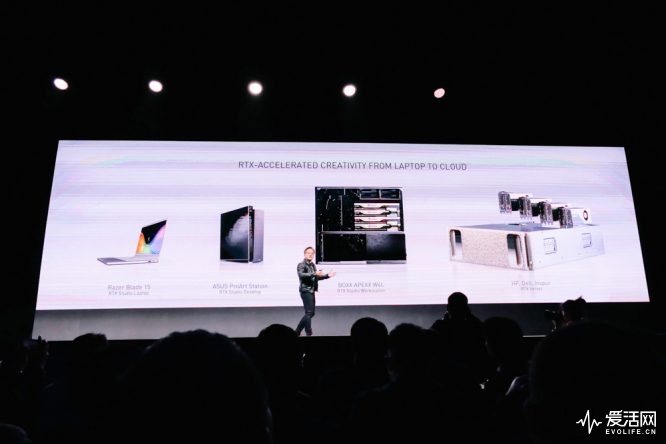

显卡性能也早已不局限在游戏中,英伟达针对RTX Studio的产品线覆盖也已经从GeForce RTX 2060笔记本覆盖到8路Quadro RTX 8000工作站。在加上NVIDIA OMNIVERSE所提供的3D制作流程的协作平台,创作者可以通过不同的分工协同工作。

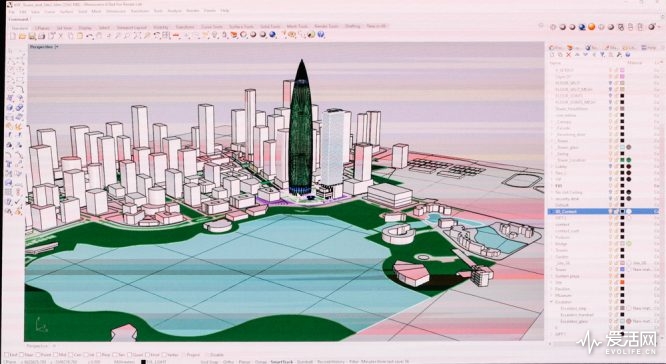

现在NVIDIA OMNIVERSE也已经正式进驻建筑行业AEC,可以做到无论本地还是云端,主流应用都能依靠NVIDIA RTX展开建模、着色、动画、视觉效果等等。在演讲台上,老黄也豪气的演示如何利用8 路 RTX 8000 的 RTX 服务器对深圳华润大厦实时渲染。

在电影、视觉特效领域,瑞云云端渲染平台也宣布配备NVIDIA RTX GPU。瑞云目前是全亚洲最大的云渲染平台,2019年火爆的《战狼2》、《哪吒》、《流浪地球》渲染均来自瑞云,超过85%的中国电影工作室都是瑞云的客户。很快,首批5000片RTX GPU也将会在2020年上线。

在现场,黄仁勋也不忘搬出那句经典台词:“买的越多,省得越多”,针对渲染工作,RTX GPU能够做到速度比CPU快12倍,价格低7倍。原本CPU上需要花费485个小时的渲染场景,交给RTX GPU现在可能只需要40个小时就能完成。

跳出大家耳熟能详的游戏、渲染领域,NVIDIA也已经将视野放向了外太空。NASA计划在2030年将6位宇航员送向火星,着陆器将以12000千米/小时的速度进入火星大气层,而且必须精确点火减速并在6分钟内降落在火星表面。

为此NASA借助NVIDIA GPU通过FUN3D流体李璇软件进行了数十万次火星着陆场景模拟,将产生的150TB数据变成了可视化,现在,NVIDIA DGX-2上已经可以借助Magnum IO GPU Direct Storage技术,对数据进行可视化处理,这在以前是不敢想象的。

如果登陆火星还不够,科研人员也正在借助GPU内的CUDA核心对全基因组进行测序。通过全基因组测序分析整个基因序列,可以检测由遗传性疾病引起的DNA变异。为此,NVIDIA推出了一套Parabricks 基因组分析工具包,借助CUDA基因测序可以加速到30-50倍完成。

而即将到来的5G与NVIDIA也同样有关系。目前NVIDIA已经与爱立信展开合作,通过CUDA核心,能够提升5G vRAN性能,特别是在复杂的空间内,CUDA能够加速解决物理空间内的信号优化的问题。

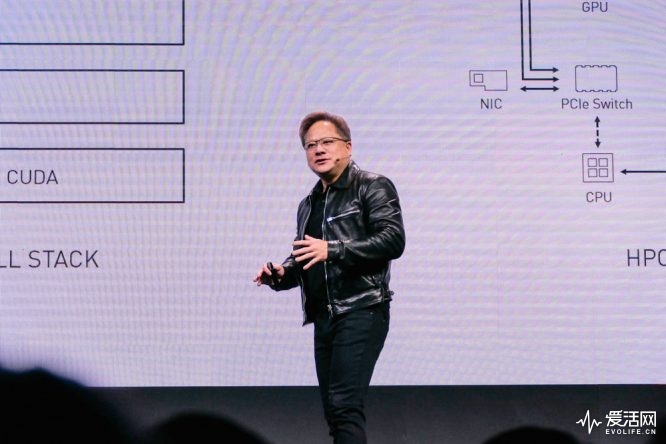

针对世界上最普及的ARM,NVIDIA也给出了一套能够与ARM配套的解决方案。得益于PCIe标准,GPU也可以轻松与ARM完成连接。基于ARM,NVIDIA推出了NVIDIA HPC for ARM首个参考架构,可以使用Marvell、Ampere、富士通亦或者其他ARM的HPC处理器与Volta GPU连接。更厉害的是,每个ARM CPU最多可以连接4块Volta GPU,扩展性能极其恐怖。

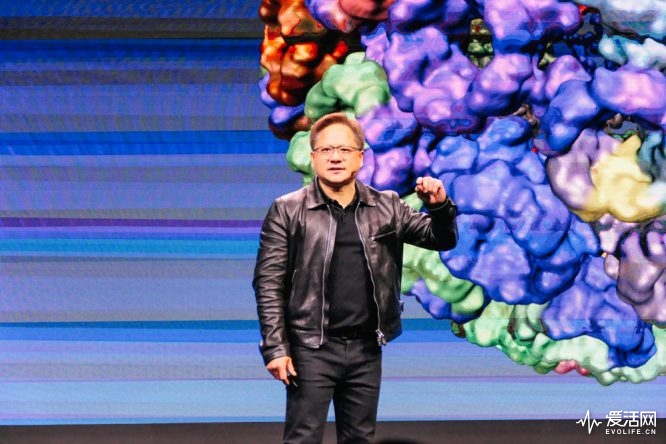

在现场,黄仁勋也毫不吝啬的通过VMD ON ARM通过CUDA演示NAMD分子动力学模型的结果可视化处理,借助Marvell ThunderX2以及NVIDIA V100,并通过NVIDIA Optix光线追踪器,并实现远程流式传输。

与此同时TensorFlow作为当今最重要的可言、云计算、工业、上也领域的HPC应用,也同样被NVIDIA CUDA on ARM所支持。

而随着深度学习不断挖掘,NVIDIA在5年左右的时间内将训练性能提高了300倍以上,借助Volta、Tensor Core GPU、Chip-on-wafer封装、HBM 3D堆栈存储器、NVLink、DGX系统,AI加速变得更快。

事实上NVIDIA AI已经影响到了各行各业,它出现在运输、医疗、金融、零售中,NVIDIA也不断为每种场景打造不同的平台,例如用于深度学习训练的DGX,用于超大规模云的HGX,用于边缘计算的EGX,用于自治系统的AGX。

现在,NVIDIA AI也已经被运用到百度推荐系统中,100多个推荐模型在百度中付诸实践,这些模型每周都会进行更新,自动学习用户潜在兴趣,新条目和特征被持续更新。目前百度庞大的用户潜在兴趣数据包含了千亿维稀疏离散特征和10TB embedding词表,只有通过GPU加速训练,才能在如此大规模的训练中加速且节省成本。

同样,阿里巴巴也接祖了NVIDIA加速计算平台大规模部署先进的AI技术,包括T4 GPU、cuBLAS、自定义混合精度和推理加速软件等。确保双十一期间2684亿人民币,每秒几十亿次推荐请求,确保全天销售额顺利推进,所以一切也都借助了NVIDIA AI的运算支持。在NVIDA AI加持下,阿里巴巴已经嫩巩固支持比过去复杂6倍的模型,从而使点击率提高10%。相比于CPU,T4将我们最大模型的吞吐量提高了100倍。

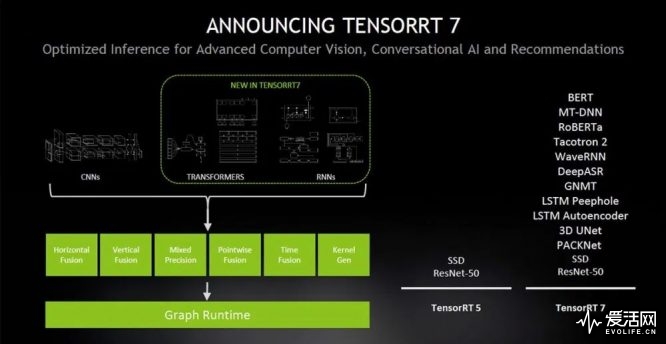

在帮助各大厂商推进AI的同时,NVIDIA也发布了全新的NVIDIA TensorRT 7推理软件,TensorRT 7内置新型深度学习编译器。该编译器能够自动优化和加速递归神经网络与基于转换器的神经网络。这些日益复杂的神经网络是AI语音应用所必需的。与在CPU上运行时相比,会话式AI组件速度提高了10倍以上,从而将延迟降低到实时交互所需的300毫秒阈值以下。

也就是说,在一套端到端的流程中,CPU推理延迟大概在3秒左右,但在T4 GPU上,整个过程只需要0.3秒。更重要的,原本TensorRT 5大概智能实现数十种不同的计算变化和优化,但到了TensorRT 7,已经可以做到1000种以上。

黄仁勋表示,现在技术已经进入了一个机器可以实时理解人类语言的AI新时代。在原有的TensorRT 5的基础上,各地开发人员能够更快部署会话式AI服务,从而实现更自然的AI人机交互。在首批使用NVIDIA会话式AI加速能力的企业中,包括了阿里巴巴、百度、滴滴出行、美团、快手、平安、搜狗、腾讯和字节跳动等中国企业。

针对自动驾驶领域,NVIDIA发布了Xavier继任者NVIDIA DRIVE AGX Orin。顾名思义,Orin是下一代机器人处理器SoC,它参数十分亮眼,包括170亿个晶体管,8核64位CPU,200TOPS深度学习算例,重点是,它的计算性能相当于Xavier的7倍。这意味着这是一个从底层架构上更新的AGX处理器,它的设计最早来自超算,拥有全新的功能安全特性,可以使CPU、GPU锁步运行而提升容错性,并且配备了全新的安全引擎保护数据不受网络攻击,以及与上一代Xavier兼容。

通过不同的组合,NVIDIA DRIVE 能够适配L2到L5级别的自动驾驶功能,其中Orin能做到与Xavier兼容,完全由软件定义。

在Orin宣布的同时,NVIDIA也宣布为滴滴提供自动驾驶和云计算解决方案,通过NVIDIA DRIVE,以及数据中心的NVIDIA GPU训练机器学习算法,滴滴已经能够实现L4几倍的自动驾驶推理能力。

作为滴滴自动驾驶AI处理的一部分,NVIDIA DRIVE借助多个深度神经网络融合来自各类传感器(摄像头、激光雷达、雷达等)的数据,从而实现对汽车周围环境360度全方位的理解,并规划出安全的行驶路径。

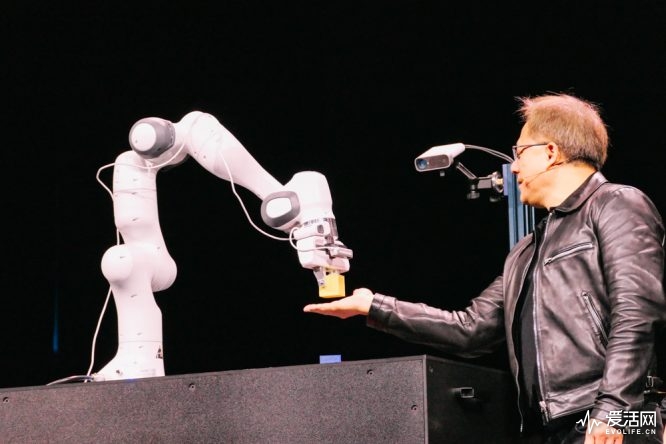

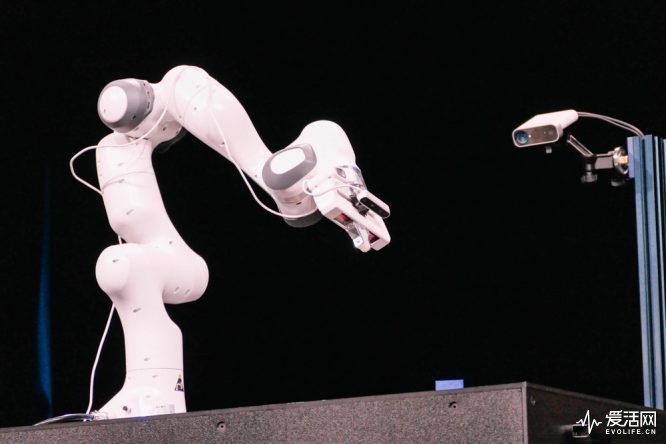

整场演讲的重头戏,最终留给了Isaac SDK。Isaac SDK包括Isaac Robotics Engine(提供应用程序框架),Isaac GEM(预先构建的深度神经网络模型、算法、库、驱动程序和API),用于室内物流的参考应用程序以及Isaac Sim的第一个版本(提供导航功能)。

全新Isaac SDK可以大大加快研究人员、开发人员、初创企业和制造商开发和测试机器人的速度。它使机器人能够通过仿真获得由人工智能技术驱动的感知和训练功能,从而可以在各种环境和情况下对机器人进行测试和验证。

这个套件包含了Training-in-Sim工作流,使用随机域生成6D姿态图像,用于训练目标检测、像素分割、2D姿态、3D姿态等诸多内容。

最后现场,NVIDIA也给我们展示了一个会卖萌的Leonardo物体操纵机器人。通过模拟和真是世界的学习,Leonardo学会了如何遵守物理规则,在模拟的计算部分则运用到了GPU的PhysX 5.0物理引擎。

可以看到长达2小时的GTC CHINA 2019演讲中,新推出的芯片只有Orin一块。NVIDIA更多的重心放在了软件平台和AI智能优化上,通过硬件与软件配合,发挥CUDA给GPU带来的大规模并行处理优势,使得GPU走出游戏和渲染,找到了一个更广阔的空间。NVIDIA造GPU无疑是最擅长的,如何用好GPU,则需要无数工程师努力挖掘答案。无论是超算、AI、自动驾驶、边缘计算,NVIDIA都已经牢牢占住了自己的位置,足以见得GPU对专业领域而言,同样具备强烈的吸引力。