不测RTX都是耍流氓

RTX的原理特性方面我就不过多复述,如果不明白可以去看看之前Edison的文章:追光者 NVIDIA GeForce RTX 2080 Ti图灵架构浅析 https://www.evolife.cn/computer/188562.html

之前其他媒体的RTX显卡评测都没有提及RTX性能,我觉得这和耍流氓无异。黄仁勋在发布会上信誓旦旦的宣布有XX款游戏支持RTX,但这个只是画饼,现在能够提供演示视频的都是寥寥无几,仅仅只有战地V、古墓丽影暗影、控制和地铁,还有Gaijin的荣誉入伍,而其他的连宣传视频都拿不出这说明八字还没一瞥。但这并不意味着RTX没有东西可测,其实NVIDIA在NDA解禁之前就提供了星球大战的Reflections Demo。当然跑这个techdemo并非一帆风顺,首先它需要1803系统,之前的1709不行,最新的秋季更新1809也不行,我为此还专门为此下载1803安装了个专门的RTX系统,此外运行之前还需要开启系统的开发者模式。

这个Demo是由NVIDIA和卢卡斯旗下的工业光魔共同开发,具体的RTX画面表现我觉得很难用静止的图片来传达,因此献上了使用GeForce RTX 2080 Ti录制的视频来展现光线追踪的惊艳。

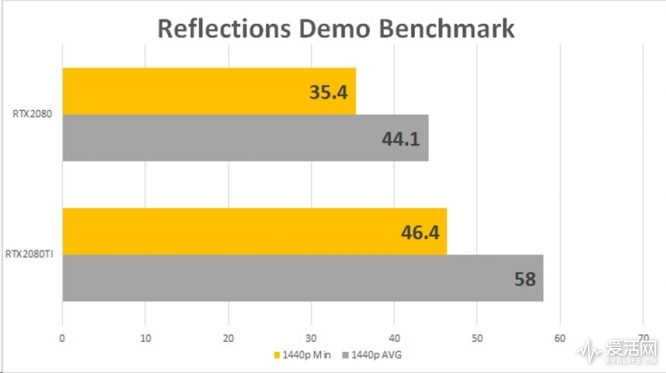

这里我来说说具体性能,这个Benchmark存在Bug,虽然说明有1080p分辨率,但实际运行是2K分辨率,而2K分辨率实际是1080p DLSS上去的,因此我们测试2K分辨率DLSS的性能,这个Demo默认有24FPS的限制,需要按F3 unlock。由于这个Techdemo是DX12,Fraps并不能支持,我们使用MSI Afterburnner的Benchmark进行测试。GeForce RTX 2080 Ti的平均FPS接近60FPS,为58FPS,但最低FPS为46.4 FPS,并不能说流畅,而GeForce RTX 2080的性能为44.1FPS,性能大概是GeForce RTX 2080 Ti的76%。RTX 2080和RTX 2080TI的RTX-OPS (Tera-OPS)分别是60/78,其性能比例也大概是76.9/100,两者之间实际测试性能差距十分符合预期。

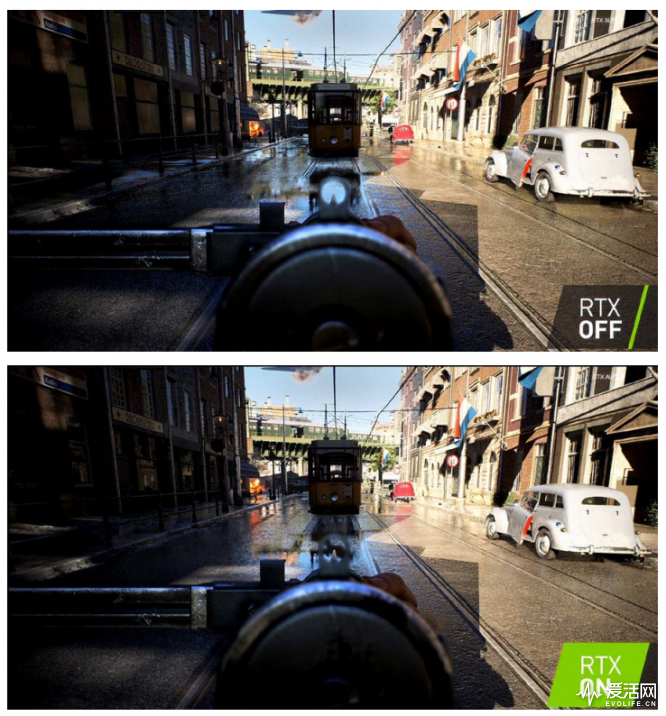

虽然这个techdemo惊艳,惊艳到GeForce RTX 2080 Ti都不能完美运行,但并不完全是理想中的光纤追踪,整体构建还是以传统的光栅化为主,RTX主要是用来实现反射和折射,依然使用了AO这样的传统技术。

实际的游戏更加如此,虽然添加RTX,但也是十分表层的特效,如古墓丽影暗影只是用来绘制光线追踪的阴影,而战地V的RTX只是用来生成反射,基础的光照系统依然还是传统的光栅化,RTX仅仅是锦上添花,视觉上并不如星球大战的Techdemo那样惊艳。但即使如此,按照之前Gamecom发布会现场展示的古墓丽影和后继youtube职业主播对战地V的反馈来看,这样表层的RTX依然需要巨量的系统资源,大大拖累了整体性能。

对于性能消耗《控制》的开发商Remedy做了详尽的解释,RTX 2080TI使用Northlight引擎在1080P分辨率下开启RTX渲染一个布置有家具大理石地面的房间,桢生成时间平均要延长9.2mm,其中2.3ms是阴影计算,4.4ms是反射计算,2.5mm是全局光照降噪。但Remedy并没有说明具体性能,我们可以做个简单计算,如果不开启RTX 100FPS,就是每帧10ms,开启RTX就是19.2ms,这就等于是52FPS,性能基本由一半的拖累,如果不开启RTX是60FPS,那每帧16.667ms,加上RTX的9.2ms就是25.87ms,那就等效于38.66FPS。如果RTX ON的单帧渲染时间固定,传统RTX OFF的性能越高,RTX ON的性能损失比例就越大,而传统方式FPS越低开启RTX的性能损失就越承受不起。Remedy表示可以进一步优化RTX的效能,但RTX的系统消耗我们需要个正确的认识。

![@]CRI[_PX9J`M6~)R8$TI_4](https://file.evolife.cn/2018/10/@CRI_PX9JM6R8TI_4-666x374.png)

虽然Windows 10最近的秋季更新在系统底层增加了对DXR的支持,扫清了系统层面的障碍,但这并不意味着RTX的发展会一帆风顺。其现在遇到的问题和当年PhysX GPU加速遇到的情况类似:性能影响大,仅仅是表层特效对画面改善不大,支持硬件平台少,特别是被家用机平台拖累。在前几年的几代RTX卡上,我们并不能指望能够发生太大的根本性改变,一方面是RTX性能不能满足大场景更高RTX的性能需求,而只能作为光栅化的不错实现一些表层特效,另外一方面AAA平台开发商首先还是需要顾及非RTX平台特别是用户基数巨大的家用机平台的情况。虽然有了RTX其实还会简化一些开发,使用自然光路并不用美工做那么多额外的预烘培,但开发商首先还是考虑广大不支持RTX平台特别是广大的家用机平台,传统光栅化的开发依然不能省去,而开发RTX又会增加额外的成本,除非是用Gameworks合作的方式,一般开发商的热情并不会太高。当然对于有追求的开发商还是会十分乐趣摘得这个图像皇冠上的明珠,如DICE,EPIC,特别是EPIC如果能够将RTX集成进Unreal Engine 4 SDK使得其实现不再困难,必将大大推进RTX的普及和发展的进程。现在RTX的显卡仅仅是完全的光绪追踪而彻底抛弃光栅化的万里长征的一小步,但却是坚实的一步,有意义的一步,并且这一步终归是需要走下去,就是早晚的问题。现在购买RTX显卡就是为未来以光线追踪构建的更为美好的图形世界添砖加瓦做贡献,因此我祈求各位还是老老实实掏出一万元。

前RTX时代的用户抉择

图灵增加了用于光线追踪的RT Core和用于深度学习的Tensor Core,就说这部分的投入,对于普通玩家而言并不是马上可以获得收益的,但用户需要为这部分付出额外的金钱。NVIDIA在Maxwell以后,将专业卡和游戏卡分开,很大程度都是为了使得每一个晶体管都是为了游戏。NVIDIA和AMD的GPU竞争很大程度上就是单位mm2芯片的游戏性能的竞争。这并不是NVIDIA第一次这样玩,上一次这样玩还要追溯到GT200,就是GTX280时候,当时NVIDIA为了迎合GPGPU的行业应用趋势为GT200加入了FP64双精度,但代价是很大程度导致了单位mm2的游戏性能不佳,虽然Radeon HD4850/4870在绝对性能上比不过,但单位mm2的效能更高,性价比更有优势,迫使当时576mm2大核心的GTX260/275卖到1xxx元的价位,可谓惨烈。

大核心的GTX260甚至卖到千元以下,此时距离下代的GTX480发售还有还有差不多半年时间。08年到09年这段时间对于NVIDIA可谓痛苦不堪回首,但对于玩家而言则是幸福的时光,不仅有便宜的次旗舰显卡,还有Crysis这样完全引导一个时代的革命性游戏大作。

现在AMD的弱势并不是在于缺乏性能旗舰,而是单位mm2的游戏性能的问题,GTX1080/1070TI的核心面积为314mm2,但和其性能同级的Vega 64/56的核心面积则高达510mm2,现在NVIDIA敢这样玩,主要是自己有足够的性能优势,特别是在今年RTG除了个7nm Frontier并无新品的时候才敢这样玩。Tensor Core和RT Core不同于之前的FP64那样没有明确的通用应用范围,而是从中长期可以带来整体变革的技术,这一步必须走,但在双方产品竞争激烈的时候必然不合适(如明年7nm NAVI发布的时候)。

Pascal和Turing还将会并存一段时间,用户对卡的选择的问题,就如我游戏性能测试部分提及的,主要取决于你玩的游戏和显示器类型,如果你终极的3A画面党,热衷于全最高特效的4K、HDR还有RTX,那GeForce RTX 2080 Ti则是你的不二选择,如果你吃鸡能够更为稳定的跑在144,那GeForce RTX 2080 Ti也会对你有足够的吸引力。,如果你是个性能实用派,那较低规格的GeForce RTX 2080 Ti就可以,但在你已经花费万元决定选择GeForce RTX 2080 Ti的时候,同时也希望获得更好的超频性能、更好散热和更低噪音的时候,你就应该选择一块高规格的非公,再者,你想构建一套全AURA RGB同步的酷炫主机,那么支持AURA的玩家国度ROG STRIX RTX 2080 TI GAMING OC才是你的最终选择。

感觉16nm没用多久。。。

12其实还是16nm 3-4年差不多了

什么?明年就7nm了吗?

明年就出7nm性能翻倍?那今年还买个鸡儿又贵性能提升又小的半成品!!

台巴子的7纳米你敢信?呵呵

坐等2060

2060要春节后了

钱包保不住了,9900K和Z390马上就要上,这一轮台式机升级怕是躲不过

抱住我心爱的钱包